2. 北京化工大学 信息中心,北京 100029

2. Center for Information Technology, Beijing University of Chemical Technology, Beijing 100029, China

鲁棒主成分分析(RPCA)是低秩恢复问题的一种。Candès等[1]提出基于矩阵的RPCA方法(matrix RPCA, MRPCA), 能够从被稀疏大噪声损坏的观测数据中恢复出隐含的低秩分量;MRPCA将观测数据分解为低秩分量和稀疏分量,用矩阵核范数约束低秩分量,矩阵范数约束稀疏分量。该模型简单且易于求解,被广泛应用在视觉处理任务中,如图像恢复和背景建模[1-2]。但是MRPCA方法会将观测数据矩阵化,这样的预处理步骤会导致不必要的信息损失,带来次优的恢复结果。针对此问题,许多基于张量的RPCA方法被相继提出,如基于Tucker分解[3]的求和核范数(sum nuclear norm, SNN)模型[4]、基于张量火车分解[5]的张量火车核范数(tensor train nuclear norm, TTNN)模型[6]和基于张量环(tensor ring, TR)分解的鲁棒张量环补全(robust tensor ring completion, RTRC)模型[7]等。为了刻画张量不同模型之间的相关性,研究者们在SNN、TTNN和RTRC中通过特殊的矩阵化策略将张量展开为一组矩阵,提出了可用交替方向乘子算法(ADMM)求解的张量鲁棒主成分分析(tensor-RPCA, TRPCA)模型。Kilmer等[8]提出了一种新的张量乘法t积(tensor-tensor product)和张量奇异值分解(tensor singular value decomposition, t-SVD)策略。在t积和t-SVD的张量框架下,Lu等[2]提出了张量核范数(tensor nuclear norm, TNN)概念,Zhou等[9]提出了张量低秩表示(low rank tensor representation, LRTR)模型。在TNN和LRTR模型中,以基于t积的张量核范数t-TNN作为tubal秩的凸包络,t-TNN等价于张量的所有前切片组成的块循环矩阵的核范数或者张量按模3方向作离散傅里叶变换所得张量的所有前切片组成的块对角矩阵的核范数,因此t-TNN可以看作一种特殊的矩阵化方式,用来刻画张量的空间信息和第三通道的相关性。此外,t-SVD可以利用快速傅里叶变换加速计算,并且tubal秩可以描述张量子空间结构。上述模型在图像恢复和背景建模中取得了较好的效果,但是对输入数据低秩结构的强依赖性问题仍然没有得到解决。

针对上述问题,本文在t积和t-SVD的张量框架下提出一个增强的张量鲁棒主成分分析模型(E-TRPCA)用于图像恢复和背景建模。首先学习得到一个字典张量,并构造了一个增强的张量核范数(E-TNN)正则项;其次,在低秩张量表示的基础上,提出了一个去随机噪声的模型;最后,设计了一个高效的交替方向乘子算法来解决所提出的问题。在图像恢复和背景建模上的实验证明了所提方法的优越性。

1 张量奇异值分解框架 1.1 符号说明给定张量

| $ \operatorname{unfold}(\mathscr{A})=\left[\begin{array}{c} \mathscr{A}_{(:, :, 1)} \\ \mathscr{A}_{(:, :, 2)} \\ \vdots \\ \mathscr{A}_{(:, :, s)} \end{array}\right], \text { fold }\left(\left[\begin{array}{c} \mathscr{A}_{(:, :, 1)} \\ \mathscr{A}_{(:, :, 2)} \\ \vdots \\ \mathscr{A}_{(:, :, s)} \end{array}\right]\right)=\mathscr{A} $ |

bdiag()运算将张量

| $ \mathit{\boldsymbol{\bar A}} = {\mathop{\rm bdiag}\nolimits} (\bar{\mathscr{A}}) = \left[ {\begin{array}{*{20}{l}} {{{\bar{\mathscr{A}}}_{(:, :, 1)}}}&{}&{}&{}\\ {}&{{{\bar{\mathscr{A}}}_{(:, :, 2)}}}&{}&{}\\ {}&{}& \ddots &{}\\ {}&{}&{}&{{{\bar{\mathscr{A}}}_{(:, :, s)}}} \end{array}} \right] $ |

bcirc()运算是将张量

| $ \operatorname{bcirc}(\mathscr{A})=\left[\begin{array}{cccc} \mathscr{A}_{(:, :, 1)} & \mathscr{A}_{(:, :, s)} & \cdots & \mathscr{A}_{(:, :, 2)} \\ \mathscr{A}_{(:, :, 2)} & \mathscr{A}_{(:, :, 1)} & \cdots & \mathscr{A}_{(:, :, 3)} \\ \vdots & \vdots & \ddots & \vdots \\ \mathscr{A}_{(:, :, s)} & \mathscr{A}_{(:, :, s-1)} & \cdots & \mathscr{A}_{(:, :, 1)} \end{array}\right] $ |

定义1(t积) 给定张量

| $ \mathscr{A} * \mathscr{B}=\text { fold }(\operatorname{bcirc}(\mathscr{A}) \operatorname{unfold}(\mathscr{B})) $ |

定义2(正交张量) 如果

定义3(张量奇异值分解)[2] 给定张量

| $ \mathscr{A}=\mathscr{U} * \mathscr{S} * \mathscr{V}^{\mathrm{T}} $ |

式中,

定义4(管道秩) 给定张量

| $ \operatorname{rank}_t(\mathscr{\mathscr { A }})=\{i, \mathscr{S}(i, i, :) \neq 0\} $ |

式中,

定义5(张量核范数)[2]

| $ \|\mathscr{A}\|_*=\sum\limits_{i=1}^r \mathscr{S}_{(:, :, i)} $ |

其中, r=rankt(

引理1 张量

① ‖

②

引理2[11]

| $ \min\limits _{V V^{\mathrm{T}}=I}\langle\boldsymbol{A}, \boldsymbol{V}\rangle $ | (1) |

有全局解V*= BCT,A=BCDT是A的奇异值分解。

根据引理1,本文给出了引理2的张量推广形式。

定理1 任给张量

| $ \min\limits _{\mathscr{V} \cdot \mathscr{V}^{\mathrm{T}}=\mathscr{I}}\langle\mathscr{A}, \mathscr{V}\rangle $ | (2) |

的全局解为

证明 由引理1以及B、C的块对角结构可知,问题(2)可以分解为以下子问题

| $ \min\limits _{\bar{\mathscr{V}}_{(i, i, k)} \overline{\mathscr{V}}_{(i, i, k)}^{\mathrm{T}}=I}\left\langle\overline{\mathscr{A}}_{(i, i, k)}, \overline{\mathscr{V}}_{(i, i, k)}\right\rangle, k=1, 2, \cdots, s $ | (3) |

由引理2知,式(3)中各子问题的全局解存在,

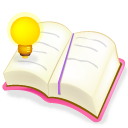

| $ \boldsymbol{X}=\boldsymbol{U} \boldsymbol{V}^{\mathrm{T}}+\boldsymbol{S} $ | (4) |

|

图 1 低秩分解 Fig.1 Low-rank factorization |

借助t积,可以把矩阵的情形推广到张量情形

| $ \mathscr{B}=\mathscr{L}+e=\mathscr{U} * \mathscr{V}^{\mathrm{T}}+ℯ $ | (5) |

事实上,如果对

| $ \|\mathscr{L}\|_{\mathrm{E}-\mathrm{TNN}}=\min\limits _{\mathscr{V} \in \mathbb{R}^w \times r \times s}\|\mathscr{L} * \mathscr{V}\|_*\\ \text { s.t. }\|\mathscr{L} * \mathscr{V}\|_F=\|\mathscr{L}\|_F\\ \mathscr{V}{ }^{\mathrm{T}} * \mathscr{V}=\mathscr{T} $ | (6) |

第一个是约束在变换结果

| $ \|\mathscr{L}\|_{\text {E-TNN }}=\min\limits _{\mathscr{U}, \mathscr{V}}\|\boldsymbol{U}\|_*\\ \text { s.t. } \mathscr{L}=\mathscr{U} * \mathscr{V}^{\mathrm{T}}, \mathscr{V}^{\mathrm{T}} * \mathscr{V}=\mathscr{T}\\ \mathscr{U} \in \mathbb{R}^{h \times r \times s}, \mathscr{V} \in \mathbb{R}^{w \times r \times s} $ | (7) |

与TNN一样,E-TNN同样作用在分量

将E-TNN正则项嵌入到TRPCA模型,得到如下低秩张量恢复模型

| $ \;\;\;\;\;\;\;\;\;\min\limits _{\mathscr{U}, \mathscr{V}, \mathscr{X}, e}\|\mathscr{U}\|\left\|_*+\lambda\right\| ℯ \|_1\\ \text { s. t. } \mathscr{X}=\mathscr{L}+ℯ\\ \;\;\;\;\;\;\;\;\;\mathscr{L}=\mathscr{U} * \mathscr{V}^{\mathrm{T}}, \mathscr{V}^{\mathrm{T}} * \mathscr{V}=\mathscr{T}\\ \;\;\;\;\;\;\;\;\;\mathscr{U} \in \mathbb{R}^{h \times w \times s}, \mathscr{V} \in \mathbb{R}^{w \times r \times s} $ | (8) |

式中

本节中,通过ADMM算法[13]求解模型(8)。由模型(8)得到以下增广拉格朗日函数。

| $ \begin{array}{l} \;\;\;\;\;\mathscr{L}\left(\mathscr{U}, \mathscr{V}, \mathscr{L}, ℯ, \mathscr{Y}_1, \mathscr{Y}_2\right)=\|\mathscr{U}\|\left\|_*+\lambda\right\| ℯ \|_l+ \\ \frac{\mu}{2}\left\|\mathscr{X}-\mathscr{L}-ℯ+\frac{\mathscr{Y}_1}{\mu}\right\|_F^2+\frac{\mu}{2}\left\|\mathscr{L}-\mathscr{U} * \mathscr{V}^{\mathrm{T}}+\frac{\mathscr{Y}_1}{\mu}\right\|_F^2 \end{array} $ | (9) |

式中,μ为惩罚项系数。ADMM可以把上述问题分解为如下的5个子问题,在每一个子问题中,固定其余变量不变,只更新一个变量。

| $ \mathscr{L}=-\frac{1}{2}\left(\mathscr{X}-e+\frac{\mathscr{Y}_1}{\mu}+\mathscr{U} * \mathscr{V}^{\mathrm{T}}-\frac{\mathscr{Y}_2}{\mu}\right) $ | (10) |

| $ \;\;\;\;\;\;\;\mathscr{U}^*=\min\limits _{\mathscr{U}}\|\mathscr{U}\|_*+\frac{\mu}{2}\left\|\mathscr{L}-\mathscr{U} * \mathscr{V}^{\mathrm{T}}+\frac{\mathscr{Y}_2}{\mu}\right\|_F^2=\\ \min\limits _{\mathscr{U}}\|\mathscr{U}\|_*+\frac{\mu}{2}\left\|\mathscr{U}-\left(\mathscr{L}+\frac{\mathscr{Y} 2}{\mu}\right) \mathscr{V}\right\|_F^2 $ | (11) |

这个子问题可以通过张量奇异值阈值算子[2]求解

| $ \mathscr{U}_*=\mathscr{D}_{\frac{1}{\mu}}\left(\left(\mathscr{L}+\frac{\mathscr{Y} 2}{\mu}\right) \mathscr{V}\right) $ | (12) |

| $ \;\;\;\;\;\;\;\;\;\mathscr{V}^*=\min\limits _{\mathscr{V}} \frac{\mu}{2}\left\|\mathscr{L}-\mathscr{U} * \mathscr{V}^{\mathrm{T}}+\frac{\mathscr{Y}_2}{\mu}\right\|_F^2=\min\limits _{\mathscr{V}} \frac{\mu}{2}\langle\mathscr{U} *\\ \left.\mathscr{V}^{\mathrm{T}}-\mathscr{P}\left(\mathscr{U} * \mathscr{V}^{\mathrm{T}}-\mathscr{P}\right)^{\mathrm{T}}\right\rangle=\min\limits _{\mathscr{V}} tr\left(\mathscr{P}^{\mathrm{T}} * \mathscr{U} *\right.\\ \left.\mathscr{V}^{\mathrm{T}}\right)_{(:, :, 1)}=\min\limits _{\mathscr{V}}\left\langle\mathscr{P}^{\mathrm{T}} * \mathscr{U}, \mathscr{V}\right\rangle $ | (13) |

由定理1可知

| $ \left\{\begin{array}{l} {[\mathscr{B}, \sim, \mathscr{C}]=\mathrm{t}-\mathrm{svd}\left(\mathscr{P}^{\mathrm{T}} * \mathscr{U}\right)} \\ \mathscr{V}^*=\mathscr{B} * \mathscr{C}^{\mathrm{T}} \end{array}\right. $ | (14) |

| $ ℯ^*=\min\limits _ {ℯ}\|ℯ\|_1+\frac{\mu}{2}\left\|\mathscr{X}-\mathscr{L}-ℯ+\frac{y_1}{\mu}\right\|_F^2 $ | (15) |

这个子问题可以通过软阈值收缩算子[14]来得到闭式解

| $ ℯ^*=ℯ_{\frac{1}{\mu}}\left(\mathscr{X}-\mathscr{L}+\frac{ℯ_1}{\mu}\right) $ | (16) |

拉格朗日乘子

| $ \left\{\begin{array}{l} \mathscr{Y}_1=\mathscr{Y}_1+\mu(\mathscr{X}-\mathscr{L}-ℯ) \\ \mathscr{y}_2=\mathscr{Y}_2+\mu\left(\mathscr{L}-\mathscr{U} \mathscr{V}^{\mathrm{T}}\right) \end{array}\right. $ | (17) |

综上所述,求解E-TRPCA模型(8)的ADMM算法(算法1)详细过程如下。

输入:

输出:

初始化参数: 初始化

1: while 不满足收敛条件

2:

通过式(10)更新

3:

通过式(12)更新

4:

通过式(14)更新

5:

通过式(16)更新

6: 检查收敛条件

| $ \frac{\|\mathscr{X}-\mathscr{L}-ℯ\|_F^2}{\|\mathscr{X}\|_F^2} \leqslant ℯ, \left\|\mathscr{L}-\mathscr{U} * \mathscr{V}^{\mathrm{T}}\right\|_F^2 \leqslant ℯ $ |

7:

通过式(17)更新

8: end while

2.3 复杂度分析算法1以三阶张量

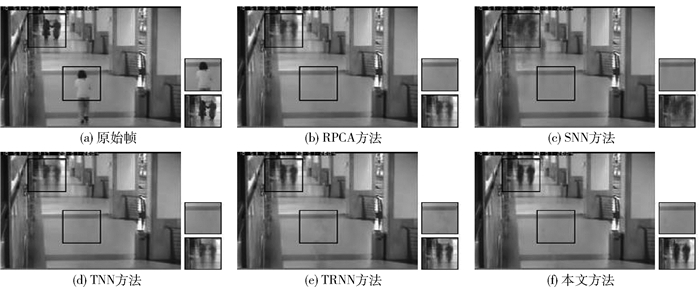

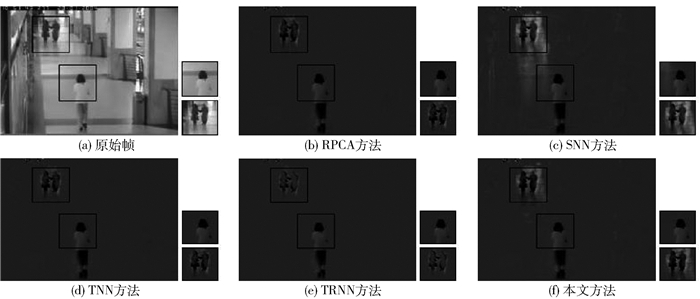

以图像恢复作为仿真实验、背景建模作为真实实验来测试所提方法,并与RPCA方法[1]、基于Tucker分解的SNN方法[4]、基于t-SVD的TNN方法[2]、基于张量火车分解的TTNN方法[6]和基于张量环分解的RTRC方法[7]这5种方法进行对比。其中,RTRC方法被用来解决张量补全问题,在本文中用于张量鲁棒主成分分析,记为TRNN(tensor ring nuclear norm)。图像恢复实验中的图片和背景建模中的视频分别用三阶张量和四阶张量存储,它们的值均被缩放到[0, 1]。

3.1 图像恢复使用伯克利分割数据集[15]中的彩色图像进行测试。图片的大小为321×481×3或481×321×3。RPCA、TNN、TRNN和本文方法可以直接处理三阶张量,TTNN方法在数据输入模型之前采用ketaugmentation (KA)技术作了数据增强处理,因此需要把图片大小调整为320×480×3,再利用KA方法将图片尺寸转化为[4×4×4×5×4×4×5×6×3]。

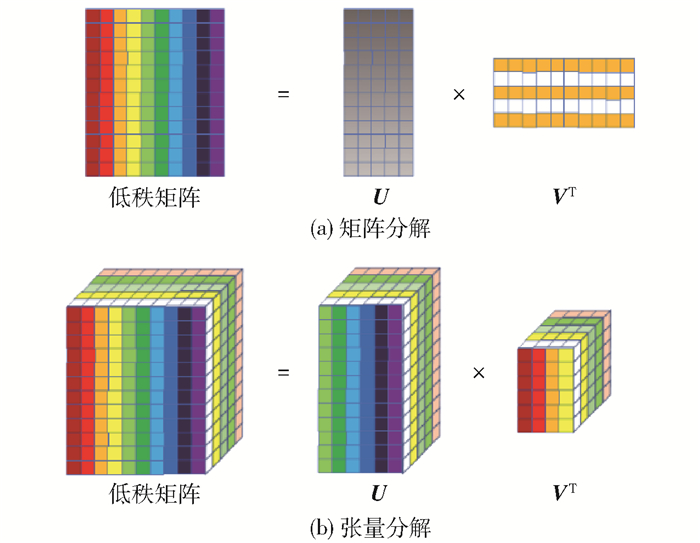

噪声模拟本文主要去除图像中的随机噪声,随机噪声比例p分别设为0.1、0.2、0.3,以p=0.1为例,即图像有10%的像素被设为区间[0, 1]之间的一个随机值,被破坏的像素的位置是随机的。

评价指标 为了评价比较方法去除随机噪声的性能,选取峰值信噪比(peak signal-to-noise ratio, PSNR)和结构相似度(structural similarity index, SSIM)作为评价指标[16],PSNR值和SSIM值越高,表示恢复结果越好。

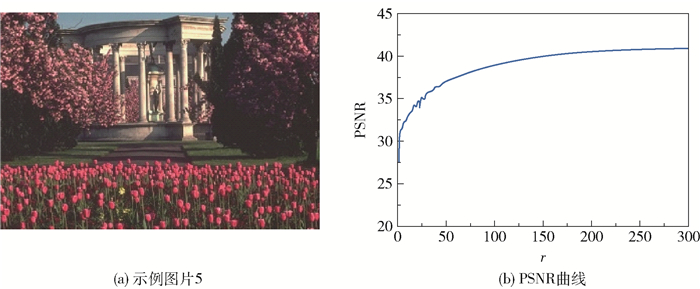

参数分析 本文提出的模型包含正则项参数λ和tubal秩r。正则项参数λ用来控制随机噪声对恢复结果的影响。由图 2知,当p=0.1时,在λ为0.045处PSNR取得最大值,p=0.2时,在λ为0.041处取得最大值,p=0.3时,在λ为0.032处取得最大值。p=0.1时,本文设定

|

图 2 p=0.1, 0.2, 0.3时,PSNR值随λ的变化曲线 Fig.2 PSNR values changing with λ for p=0.1, 0.2, 0.3 |

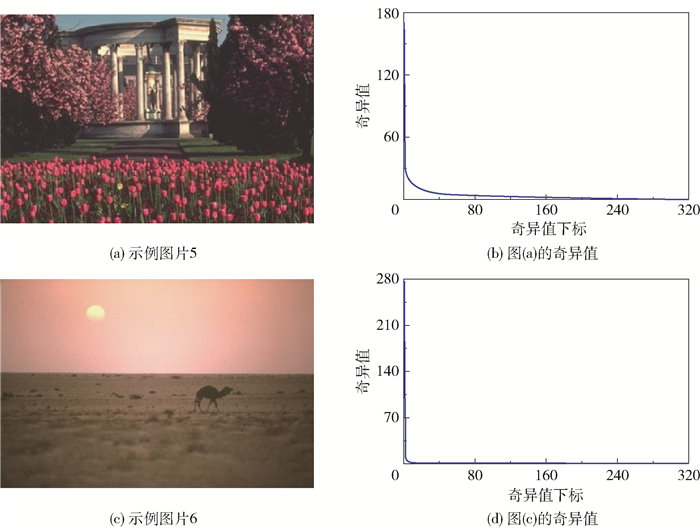

Tubal秩r用于刻画图像的低秩性。本文通过遍历r来分析tubal秩对PSNR的影响。由图 3(b)可知,随着r的增大,图像的恢复效果也越来越好。为了在效率和性能之间取得一个平衡,将r设为

|

图 3 管道秩对PSNR值的影响 Fig.3 The effect of tubal rank on PSNR value |

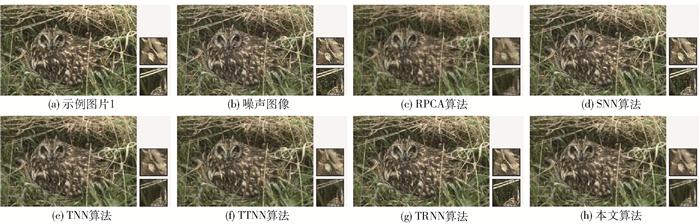

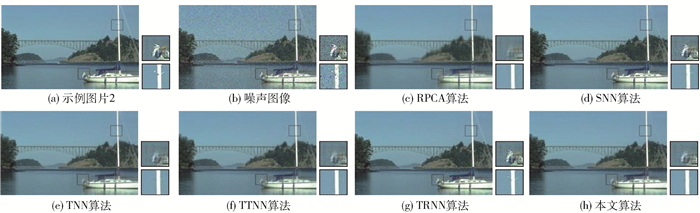

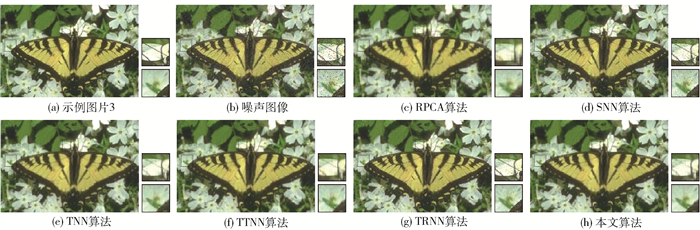

1) 视觉效果比较

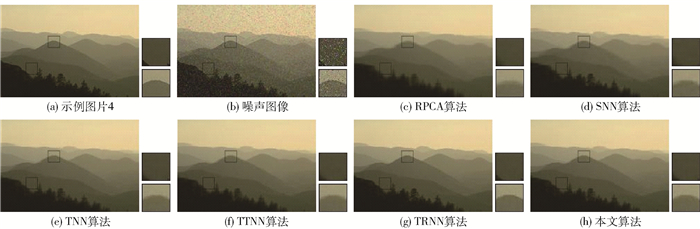

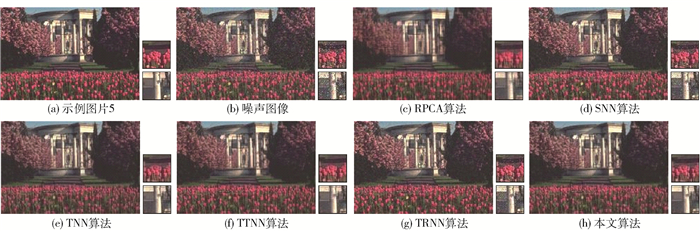

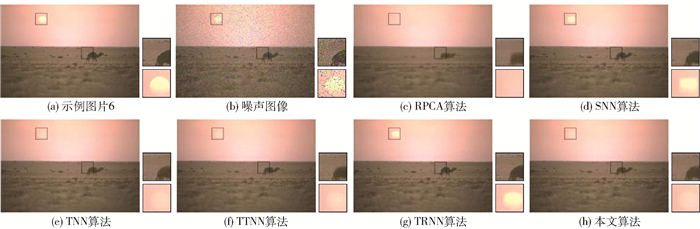

为了直观地对比图像的恢复结果,从伯克利分割数据集中选取了6张示例图片进行可视化展示。从图 4~9中可以看出,RPCA、SNN、TTNN和TRNN算法虽然能够去除图片中的随机噪声和椒盐噪声,但这4种方法不能很好地保留图像中的细节。图 4(h)~9(h)展示了本文所提模型的恢复结果,可以看到添加的噪声被去除,并且图像中的纹理和边缘也得到了很好的保留。这说明本文提出的E-TNN正则项要比t-SVD张量框架下的张量核范数更有效。

|

图 4 所有对比方法在示例图片1下的恢复结果(p=0.1) Fig.4 Restoration results of all competing methods for example image 1(p=0.1) |

|

图 5 所有对比方法在示例图片2下的恢复结果(p=0.1) Fig.5 Restoration results of all competing methods for example image 2(p=0.1) |

|

图 6 所有对比方法在示例图片3下的恢复结果(p=0.1) Fig.6 Restoration results of all competing methods for example image 3(p=0.1) |

|

图 7 所有对比方法在示例图片4下的恢复结果(p=0.1) Fig.7 Restoration results of all competing methods for example image 4(p=0.1) |

|

图 8 所有对比方法在示例图片5下的恢复结果(p=0.1) Fig.8 Restoration results of all competing methods for example image 5(p=0.1) |

|

图 9 所有对比方法在示例图片6下的恢复结果(p=0.1) Fig.9 Restoration results of all competing methods for example image 6(p=0.1) |

2) 定量结果比较

表 1~3分别是6张示例图片在不同随机噪声比例p=0.1、0.2、0.3下的PSNR值和SSIM值。可以看出,本文所提模型的PSNR评价指标在所有的噪声比例中都取得了最好的结果,而且在SSIM评价指标上也基本上取得了最优或次优的结果。

| 下载CSV 表 1 各对比方法在p=0.1下的PSNR和SSIM值比较 Table 1 Comparison of the PSNR and SSIM values obtained using all competing methods with p=0.1 |

| 下载CSV 表 2 各对比方法在p=0.2下的PSNR和SSIM值比较 Table 2 Comparison of the PSNR and SSIM values obtained using all competing methods with p=0.2 |

| 下载CSV 表 3 各对比方法在p=0.3下的PSNR和SSIM值比较 Table 3 Comparison of the PSNR and SSIM values obtained using all competing methods with p=0.3 |

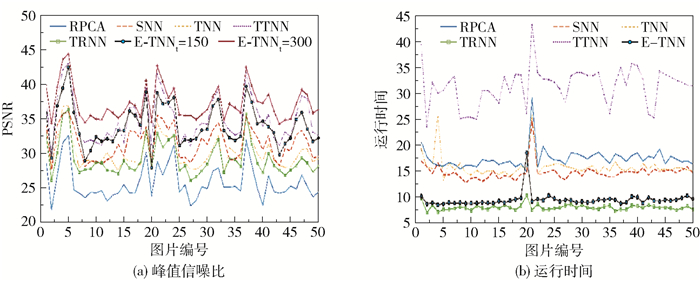

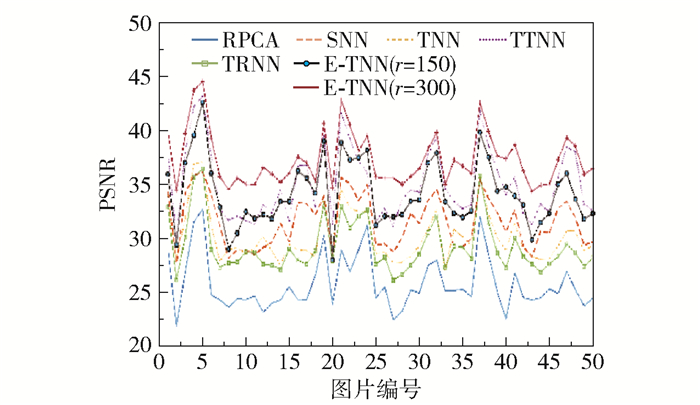

图 10给出了在p=0.1时伯克利分割数据集50张图片的PSNR值和运行时间的比较。可以看出,与其他几种算法相比,本文所提方法取得的PSNR值最高, 并且运行所需时间也仅次于TRNN方法,远低于其他方法。

|

图 10 各对比方法在伯克利分割数据集50张图像上的定量结果比较 Fig.10 Quantitative comparison of all competing methods on 50 images of the Berkeley segmentation dataset |

此外,由表 1~3可知,在示例图片1和示例图片5中,所有方法都没有取得比较好的恢复效果,而示例图片4和示例图片6的恢复效果较好。

RPCA、SNN、TNN、TTNN、TRNN等方法都假设数据具有低秩结构,对低秩性有强依赖性。我们发现,对于结构比较复杂、纹理较为丰富的示例图片5(图 11(a)),其张量奇异值并没有迅速接近于0(图 11(b)),这表明其tubal秩相对较大,上述方法难以取得好的恢复效果。而在背景空旷的示例图片6(图 11(c))中, 其奇异值则迅速接近于0(图 11(d)),表明tubal秩较小,上述方法可以取得较好的恢复效果。对此,本文新增了一个参数r用于控制tubal秩对数据恢复效果的影响,E-TRPCA模型中的λ参数可以协调核范数正则项和l1正则项,参数r则可以进一步控制核范数正则项。由图 3可知,当随机噪声比例p=0.1时,在不改变其他参数的情况下,r从0增加300,PSNR也从25增加到42,这为处理不同场景的图像提供了一个优化手段。

|

图 11 不同图片的奇异值分布 Fig.11 Singular value distribution of different images |

为了更好地评估本文模型的泛化性,图 12给出了r=150和r=300两种情况下本文方法与其他5种方法的PSNR值比较。从图中可以看出,当r取150和300时,本文所提方法取得的PSNR值都要高于RPCA、SNN、TNN、TTNN和TRNN方法,而且r=300时所得的结果要好于r=150时的结果。这说明在数据是否具有低秩性的先验信息未知的情况下,本文所提方法具有较好的泛化性。

|

图 12 r=150,300时,50张图片的PSNR值 Fig.12 PSNR values of 50 images for r= 150 ,300 |

视频的前景和背景分离任务一直以来都是研究的热点。视频由连续的帧图像序列组成,其中结构稳定、变动很小的场景内容是视频的背景。由于背景之间的相关性,可以将其视作一个低秩分量,而在视频中所占像素较小且变动显著的物体,如汽车或行人,即为视频的前景,可以视为稀疏分量。本文选取了driverway(117帧)[17]和shop(100帧)[18]两个视频。在RPCA算法中,将视频张量h×w×3×f展开为矩阵hw×3f; 在SNN、TNN、TRNN算法中,将视频张量的大小转化为hw×3×f; 在本文所提方法中,将视频张量转化为hw×f×3,f表示视频的帧数。

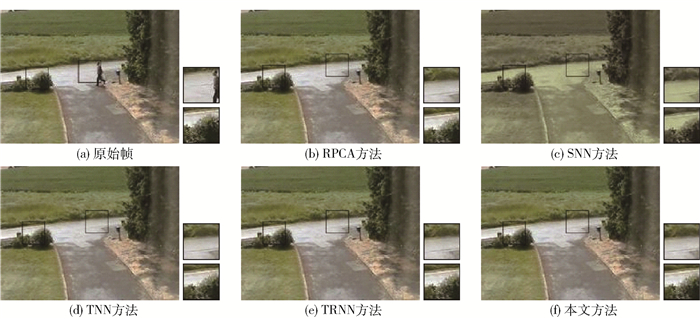

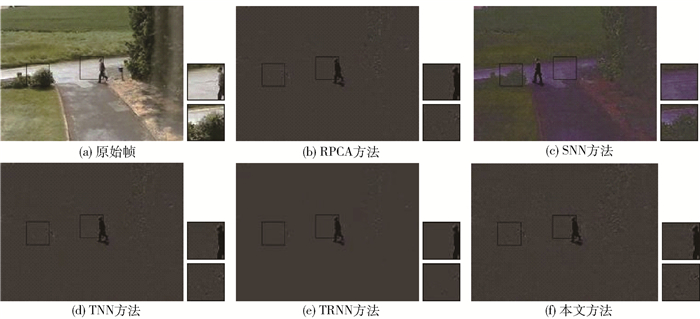

表 4为RPCA、SNN、TNN、TRNN和本文方法运行时间的比较,图 13~16给出了5种方法在两个视频上的结果(TTNN方法难以找到一个合适的KA参数,故不参与比较)。可知5种方法都可以将运动的行人从背景中提取出来,但本文方法的用时最短。

| 下载CSV 表 4 运行时间比较 Table 4 Running time comparison |

|

图 13 driverway视频的背景图像 Fig.13 Background image for driveway video |

|

图 14 driverway视频的前景图像 Fig.14 Foreground image for driveway video |

|

图 15 shop视频的背景图像 Fig.15 Background image for shop video |

|

图 16 shop视频的前景图像 Fig.16 Foreground image for shop video |

本文在原有模型的基础上新增了一个正则项

l21范数定义如下。

此时,模型(8)可以改写为

| $ \begin{array}{l} \min\limits _{\mathscr{U}, \mathscr{V}, \mathscr{X}, ℯ}\|\mathscr{U}\|_*+\lambda\|ℯ\|_1+\beta\|\mathscr{N}\|_{21} \\ \text { s. t. } \mathscr{X}=\mathscr{L}+ℯ+\mathscr{N} \\ \mathscr{L}=\mathscr{U} * \mathscr{V}^{\mathrm{T}}, \mathscr{V}^{\mathrm{T}} * \mathscr{V}=\mathscr{T} \\ \mathscr{U} \in \mathbb{R}^{h \times r \times s}, \mathscr{V} \in \mathbb{R}^{w \times r \times s} \end{array} $ | (18) |

模型(18)的增广拉格朗日函数为

| $ \begin{array}{l} \;\;\;\;\;\;\mathscr{L}\left(\mathscr{U}, \mathscr{V}, \mathscr{L}, ℯ, \mathscr{Y}_1, \mathscr{Y}_2\right)=\|\mathscr{U}\| *+\lambda\|ℯ\|_1+ \\ \beta\|\mathscr{N}\|_{21}+\frac{\mu}{2}\left\|\mathscr{X}-\mathscr{L}-ℯ-\mathscr{N}+\frac{\mathscr{Y}_1}{\mu}\right\|_F^2+\frac{\mu}{2} \| \mathscr{L}- \\ \mathscr{U} * \mathscr{V}^{\mathrm{T}}+\frac{\mathscr{Y}_2}{\mu} \|_F^2 \end{array} $ | (19) |

式(19)依然采取ADMM算法求解,与算法1相比,求解模型(8)多出一个子问题,即求解‖

| $ \mathscr{N}^*=\min\limits _{\mathscr{N}}\|\mathscr{N}\|_{21}+\frac{\mu}{2}\left\|\mathscr{N}-\left(\mathscr{X}-\mathscr{L}-ℯ+\frac{\mathscr{Y}_1}{\mu}\right)\right\|_F^2 $ | (20) |

令

| $ \left\{ {\begin{array}{*{20}{l}} {\frac{{{{\left\| {{{\cal \mathscr{C}}_{(:, j, k)}}} \right\|}_2} - \frac{\beta }{\mu }}}{{{{\left\| {{{\cal \mathscr{C}}_{(:, j, k)}}} \right\|}_2}}}{{\cal \mathscr{C}}_{(:, j, k)}}, }&{\frac{\beta }{\mu } < {{\left\| {{{\cal \mathscr{C}}_{(:, j, k)}}} \right\|}_2}}\\ {0, }&{其他} \end{array}} \right. $ | (21) |

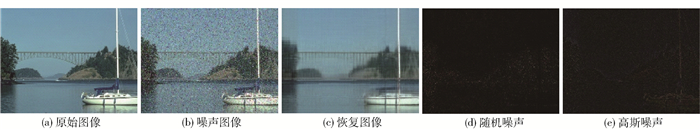

本文将模型(18)应用于图片恢复。图 17给出了本文方法去除混合噪声的可视化结果。图 17(b)是添加了均值为0、方差为0.05的高斯噪声和随机噪声比例p=0.2的示例图片2。从图 17(c)~(e)可以看出,图像的低秩部分、随机噪声部分和高斯噪声部分都被很好地分离出来。

|

图 17 混合噪声去除 Fig.17 Mixture noise removal |

本文引入了增强的TNN正则项(E-TNN),提出一种增强的TRPCA模型。与TNN相比,E-TNN能够在张量数据的子空间投影上计算低秩性,可刻画张量数据中各成分的相关性和差异,从而更真实地反映张量数据的潜在低秩结构。与张量鲁棒主成分分析方法相比,本文所提算法可以有效地恢复出被噪声破坏的图像, 并缩短运行所需时间。下一步可以基于不同维度的张量数据自动调整字典张量的维度。此外,基于广义线性变换的t积张量框架在张量低秩恢复问题中的应用将是未来的研究方向之一。

| [1] |

CANDÈS E J, LI X, MA Y, et al. Robust principal component analysis?[J]. Journal of the ACM, 2011, 58(3): 11. |

| [2] |

LU C, FENG J, CHEN Y, et al. Tensor robust principal component analysis with a new tensor nuclear norm[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(4): 925-938. DOI:10.1109/TPAMI.2019.2891760 |

| [3] |

TOCK D. Tensor decomposition and its applications[D]. Chester: University of Chester, 2010.

|

| [4] |

HUANG B, MU C, GOLDFARB D, et al. Provable models for robust low-rank tensor completion[J]. Pacific Journal of Optimization, 2015, 11(2): 339-364. |

| [5] |

YANG J H, ZHAO X L, JI T Y, et al. Low-rank tensor train for tensor robust principal component analysis[J]. Applied Mathematics and Computation, 2020, 367: 124783. DOI:10.1016/j.amc.2019.124783 |

| [6] |

DIAN R, LI S T, FANG L Y. Learning a low tensor-train rank representation for hyperspectral image super-resolution[J]. IEEE Transactions on Neural Networks and Learning Systems, 2019, 30(9): 2672-2683. DOI:10.1109/TNNLS.2018.2885616 |

| [7] |

HUANG H Y, LIU Y P, LONG Z, et al. Robust low-rank tensor ring completion[J]. IEEE Transactions on Computational Imaging, 2020, 6: 1117-1126. DOI:10.1109/TCI.2020.3006718 |

| [8] |

KILMER M E, MARTIN C D. Factorization strategies for third-order tensors[J]. Linear Algebra and its Applications, 2011, 435(3): 641-658. DOI:10.1016/j.laa.2010.09.020 |

| [9] |

ZHOU P, LU C Y, FENG J S, et al. Tensor low-rank representation for data recovery and clustering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(5): 1718-1732. DOI:10.1109/TPAMI.2019.2954874 |

| [10] |

KILMER M E, BRAMAN K, HAO N, et al. Third-order tensors as operators on matrices: a theoretical and computational framework with applications in imaging[J]. SIAM Journal on Matrix Analysis and Applications, 2013, 34(1): 148-172. DOI:10.1137/110837711 |

| [11] |

XIE Q, ZHAO Q, MENG D Y, et al. Multispectral images denoising by intrinsic tensor sparsity regularization[C]//Proceedings of the IEEE Computer Society Conference on 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, 2016: 1692-1700.

|

| [12] |

HE W, ZHANG H Y, ZHANG L P, et al. Total-variation-regularized low-rank matrix factorization for hyperspectral image restoration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(1): 178-188. DOI:10.1109/TGRS.2015.2452812 |

| [13] |

LIN Z, CHEN M, MA Y. The augmented Lagrange multiplier method for exact recovery of corrupted low-rank matrices[EB/OL]. (2013-10-18). arXiv: 1009. 5055.

|

| [14] |

CAI J F, CANDÈS E J, SHEN Z. A singular value thresholding algorithm for matrix completion[J]. SIAM Journal on Optimization, 2010, 20(4): 1956-1982. DOI:10.1137/080738970 |

| [15] |

MARTIN D, FOWLKES C, TAL D, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics[C]//Proceedings of Eighth IEEE International Conference on Computer Vision. Vancouver, 2001: 416-423.

|

| [16] |

WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. DOI:10.1109/TIP.2003.819861 |

| [17] |

BARNICH O, VAN DROOGENBROECK M. ViBe: a universal background subtraction algorithm for video sequences[J]. IEEE Transactions on Image Processing, 2011, 20(6): 1709-1724. DOI:10.1109/TIP.2010.2101613 |

| [18] |

BOUWMANS T, SOBRAL A, JAVED S, et al. Decomposition into low-rank plus additive matrices for background/foreground separation: a review for a comparative evaluation with a large-scale dataset[J]. Computer Science Review, 2017, 23: 1-71. DOI:10.1016/j.cosrev.2016.11.001 |